Modelagem e Design de Dados para Arquiteturas de Software em Big Data

No advento da era digital, a habilidade de processar e analisar grandes volumes de dados tornou-se um diferencial estratégico para organizações em diversos setores. A modelagem e o design de dados desempenham um papel fundamental neste contexto, atuando como a espinha dorsal para o desenvolvimento de arquiteturas de software que não apenas gerenciam, mas também extraem valor significativo de grandes conjuntos de dados. Esta necessidade crescente coloca em destaque a importância de entender os princípios e as práticas envolvidas na modelagem e no design de dados eficientes.

O desafio central é criar modelos de dados que sejam capazes de escalar e performar sob demandas crescentes, mantendo a integridade e a acessibilidade dos dados. Com o aumento exponencial do volume de dados, tradicionais abordagens de modelagem podem não ser mais suficientes. A motivação para explorar novos modelos e técnicas surge da necessidade de lidar com a complexidade e a variabilidade dos dados modernos, o que inclui desde dados estruturados até não estruturados e semi-estruturados.

Este artigo visa preparar o leitor para compreender as nuances da modelagem e do design de dados em cenários de big data, focando em modelos de dados para escalabilidade e desempenho, bem como em esquemas de dados e otimização de consultas. Exemplos práticos, como o uso de modelos NoSQL em sistemas de recomendação online, ilustram como a modelagem adequada pode influenciar diretamente a eficiência e a eficácia dos sistemas de processamento de dados.

Modelos de Dados para Escalabilidade e Desempenho

A escalabilidade e o desempenho em sistemas de big data são desafios críticos que demandam uma abordagem detalhada na modelagem de dados. Com o crescimento exponencial em volume, variedade e velocidade dos dados, os modelos tradicionais de bancos de dados muitas vezes se tornam inadequados. Nesta seção, exploraremos as estratégias e modelos de dados que podem efetivamente abordar essas questões.

Modelos Tradicionais vs. Modelos Não Tradicionais na Modelagem de Dados

A escolha entre modelos tradicionais e não tradicionais de bancos de dados é uma decisão crítica no design de sistemas de big data. Esta subseção aprofunda-se nessa comparação, destacando não apenas as diferenças técnicas, mas também as implicações práticas de cada abordagem.

Modelos Tradicionais: Bancos de Dados Relacionais.

Os bancos de dados relacionais, como MySQL e PostgreSQL, são baseados no modelo de dados tabular e seguem um esquema rígido. Esses sistemas são altamente normalizados, promovendo a integridade dos dados através de relações estritas e regras de consistência. No entanto, essa rigidez pode ser uma desvantagem em ambientes de big data, onde a flexibilidade e a capacidade de escalonamento horizontal são cruciais. A escalabilidade vertical (aumento da capacidade de um único servidor) é frequentemente limitada e cara, tornando esses modelos menos ideais para o processamento de grandes volumes de dados.

Modelos Não Tradicionais: Bancos de Dados NoSQL.

Os bancos de dados NoSQL, como MongoDB, Cassandra e HBase, oferecem um paradigma alternativo. Eles são projetados para escalonamento horizontal, distribuindo dados em vários servidores para lidar com grandes volumes de dados e altas taxas de transações. Diferentemente dos bancos de dados relacionais, os NoSQL frequentemente permitem esquemas flexíveis ou mesmo a ausência de esquemas, adaptando-se melhor a dados não estruturados ou semi-estruturados.

Comparação Crítica.

A escolha entre modelos tradicionais e não tradicionais depende de vários fatores. Enquanto os modelos relacionais são mais adequados para transações complexas e situações onde a integridade dos dados é primordial, os modelos NoSQL são preferíveis em cenários de big data com necessidade de rápida evolução do esquema, escalabilidade e processamento distribuído.

Por exemplo, em sistemas de IoT (Internet das Coisas), onde os dados são frequentemente não estruturados e gerados em alta velocidade, os bancos de dados NoSQL podem ser mais eficientes. Em contraste, sistemas financeiros que exigem alta consistência e transações complexas se beneficiam mais dos bancos de dados relacionais.

Escalabilidade em Modelos de Dados

No contexto de big data, a escalabilidade é um dos aspectos mais críticos na modelagem de dados. Com volumes de dados aumentando exponencialmente, a capacidade de um sistema de dados de escalar eficientemente é fundamental para manter o desempenho e a eficácia. Esta subseção aborda os diferentes aspectos da escalabilidade em modelos de dados, enfatizando sua importância em arquiteturas de software modernas.

Isso inclui o uso de sharding (particionamento de dados), replicação para garantir alta disponibilidade e técnicas de balanceamento de carga para distribuir eficientemente as solicitações entre múltiplos nós.

- Sharding e Particionamento de Dados.: Sharding, ou particionamento de dados, envolve a divisão de um banco de dados em pedaços menores e sua distribuição em vários servidores ou clusters. Esta técnica permite que cada shard seja gerenciado e escalado independentemente, facilitando o crescimento horizontal do sistema de banco de dados. O sharding é particularmente eficaz em sistemas NoSQL, onde a flexibilidade no esquema de dados suporta uma distribuição mais eficiente.

- Replicação e Consistência.: A replicação é outra estratégia fundamental para escalabilidade. Ela envolve a cópia de dados entre diferentes servidores ou clusters para garantir a alta disponibilidade. No entanto, a replicação apresenta desafios relacionados à consistência dos dados, especialmente em ambientes distribuídos. Estratégias como a consistência eventual (usada em sistemas BASE) e o uso de quorums de escrita e leitura são aplicadas para equilibrar consistência e disponibilidade.

- Automação e Orquestração.: A automação e a orquestração de recursos são essenciais para uma escalabilidade eficaz. Ferramentas de orquestração de contêineres como Kubernetes permitem o escalonamento automático de aplicações baseadas em dados, ajustando recursos de acordo com a demanda. Isso é crucial para sistemas que experimentam cargas de trabalho variáveis.

Desafios da Escalabilidade.

Enquanto a escalabilidade traz benefícios significativos, também apresenta desafios, como a complexidade no gerenciamento de dados distribuídos e a latência aumentada em operações de dados transcontinentais. A otimização de algoritmos de roteamento de dados e técnicas de caching pode ajudar a mitigar esses desafios.

Desempenho em Modelos de Dados

No universo de big data, o desempenho é um fator crítico que influencia diretamente a eficácia e eficiência de um sistema de dados. A capacidade de processar rapidamente grandes volumes de dados e fornecer resultados em tempo hábil é essencial. Esta subseção explora as diversas estratégias e práticas adotadas para otimizar o desempenho em modelos de dados, especialmente em cenários de big data.

Estratégias de Otimização de Desempenho:

- Otimização de Consultas e Indexação: A otimização de consultas é um aspecto vital para melhorar o desempenho. Isso envolve refinar a lógica de consulta para reduzir a carga de processamento e o tempo de resposta. A indexação é outra técnica crucial, que permite um acesso mais rápido aos dados ao evitar a varredura completa de tabelas ou coleções. Índices bem planejados são fundamentais em bancos de dados relacionais, mas também são relevantes em sistemas NoSQL, onde podem melhorar significativamente a eficiência das operações de leitura.

- Técnicas de Caching: O caching é uma técnica amplamente utilizada para melhorar o desempenho. Armazenando dados frequentemente acessados em uma memória mais rápida, como RAM, o sistema pode reduzir o número de acessos a discos mais lentos. Isso é especialmente útil em operações de leitura intensiva e pode significativamente acelerar o desempenho de aplicações de dados.

- Balanceamento de Carga e Processamento Distribuído: O balanceamento de carga é essencial para distribuir as solicitações de dados de maneira eficiente entre os servidores, maximizando o uso dos recursos disponíveis. Em conjunto com o processamento distribuído, como oferecido por frameworks como Apache Hadoop e Apache Spark, permite-se o processamento paralelo e eficiente de grandes conjuntos de dados, otimizando tanto o tempo de processamento quanto a utilização de recursos.

Desafios e Considerações.

Embora essas técnicas possam melhorar significativamente o desempenho, elas também apresentam desafios, como a complexidade na manutenção de índices e a gestão eficiente do cache. Além disso, o equilíbrio entre desempenho e outros fatores, como custo e complexidade de implementação, deve ser cuidadosamente considerado.

Conclusão e Leituras Futuras em Modelos de Dados para Escalabilidade e Desempenho

A modelagem de dados para escalabilidade e desempenho em sistemas de big data é um campo dinâmico e essencial na era atual da informação. Esta seção destacou a importância de escolher o modelo de dados adequado – seja tradicional ou não tradicional – com ênfase na otimização para escalabilidade e desempenho. A capacidade de um sistema de se adaptar a volumes crescentes de dados e manter um alto nível de desempenho é crucial para o sucesso em uma variedade de aplicações, desde análises de negócios até sistemas de inteligência artificial.

A escolha entre modelos de dados tradicionais e não tradicionais deve ser guiada pelas necessidades específicas do projeto e pelo tipo de dados manipulados. Enquanto os modelos relacionais são ideais para dados altamente estruturados com exigências de integridade e consistência, os modelos NoSQL são mais flexíveis, escaláveis e adequados para dados semi-estruturados ou não estruturados.

À medida que os volumes de dados continuam a crescer e se tornam mais complexos, os desafios associados à modelagem de dados para escalabilidade e desempenho também evoluem. Portanto, é imperativo estar atualizado com as tendências e inovações mais recentes na área.

Esquemas de Dados e Otimização de Consultas em Big Data

A otimização de esquemas de dados e consultas é crucial em ambientes de big data. Esta seção aborda as práticas e técnicas avançadas usadas para otimizar esquemas e consultas, garantindo que os sistemas de dados sejam não apenas eficientes, mas também escaláveis e confiáveis.

Estratégias de Otimização de Esquemas

A otimização de esquemas em ambientes de big data é uma área complexa que requer uma compreensão aprofundada tanto do modelo de dados quanto das necessidades específicas de aplicação. Esta subseção explora estratégias avançadas para otimizar esquemas de dados, focando em como melhorar a eficiência e eficácia do armazenamento e recuperação de dados em grande escala.

Estratégias de Otimização de Esquemas:

- Normalização e Denormalização: A normalização, que visa reduzir a redundância de dados e aumentar a integridade, pode ser contraproducente em cenários de big data devido ao aumento das operações de junção. Em contraste, a denormalização, embora aumente a redundância, pode melhorar significativamente o desempenho das consultas em grandes datasets, simplificando as estruturas de dados e reduzindo a necessidade de junções complexas.

- Modelagem de Dados Multidimensional: A modelagem de dados multidimensional é particularmente eficaz em ambientes de análise de dados, como data warehouses. Ela facilita consultas analíticas rápidas e eficientes, organizando dados em cubos que permitem análises a partir de múltiplas perspectivas. Essa abordagem é especialmente útil para operações de OLAP (Online Analytical Processing).

- Esquemas Flexíveis em NoSQL: Bancos de dados NoSQL, ao oferecerem esquemas flexíveis, permitem uma adaptação mais rápida e eficiente às mudanças nos padrões de dados. Esta flexibilidade é crucial em cenários de big data, onde a variabilidade e a evolução dos dados são constantes. A escolha do tipo de banco de dados NoSQL (documentos, chave-valor, colunar ou gráfico) deve ser alinhada com as características dos dados e os requisitos das consultas

- Técnicas Avançadas de Particionamento: O particionamento de dados em esquemas otimizados pode aumentar significativamente o desempenho, especialmente em sistemas distribuídos. A escolha de uma estratégia de particionamento apropriada (horizontal, vertical ou funcional) deve considerar o tamanho do dataset, o padrão de acesso aos dados e a arquitetura do sistema.

Desafios e Considerações Futuras.

A otimização de esquemas em big data apresenta desafios únicos, como a necessidade de equilibrar a flexibilidade do esquema com o desempenho e a escalabilidade. Além disso, a manutenção de esquemas otimizados em um ambiente de dados em constante mudança requer uma abordagem adaptativa e proativa.

Técnicas de Otimização de Consultas em Big Data

No contexto de big data, a otimização de consultas é fundamental para garantir o acesso rápido e eficiente a grandes volumes de dados. Esta subseção explora diversas técnicas de otimização de consultas, enfocando como elas podem ser aplicadas para melhorar o desempenho em ambientes de big data.

- Indexação Estratégica: A indexação é uma das ferramentas mais poderosas na otimização de consultas. Em ambientes de big data, a escolha de índices adequados é crítica. Índices bem projetados podem reduzir drasticamente o tempo de acesso aos dados, especialmente em operações de leitura frequentes. A implementação de índices compostos, que combinam múltiplas colunas, pode ser particularmente eficaz para consultas complexas.

- Otimização de Consultas em SQL: Para bancos de dados que utilizam SQL, a otimização de consultas envolve a reescrita de queries para aumentar a eficiência. Técnicas como a seleção cuidadosa de predicados, o uso eficiente de JOINs e a limitação de subconsultas podem reduzir significativamente o tempo de execução. Ferramentas de análise de consultas, como os planos de execução, são indispensáveis para identificar gargalos e oportunidades de otimização.

- Processamento Paralelo e Distribuído: Em sistemas distribuídos como Hadoop e Spark, o processamento paralelo e distribuído de consultas é essencial. Esses sistemas dividem as consultas em tarefas menores que são executadas simultaneamente em vários nós, melhorando significativamente o desempenho em grandes conjuntos de dados. A otimização aqui envolve a eficiente distribuição de dados e a minimização do tráfego de rede entre os nós.

- Caching e Materialização de Consultas: O caching de resultados de consultas frequentes pode melhorar drasticamente o tempo de resposta. Além disso, a materialização de consultas, onde os resultados são pré-calculados e armazenados, pode ser uma estratégia eficaz para consultas complexas e repetitivas.

Desafios e Estratégias Futuras.

A otimização de consultas em big data é um campo em constante evolução, com novos desafios surgindo à medida que a tecnologia e os volumes de dados crescem. Estratégias como aprendizado de máquina para otimização automática de consultas estão começando a ser exploradas e prometem transformar a forma como as consultas são otimizadas.

Desafios da Otimização em Big Data

- Complexidade e Variabilidade dos Dados: A otimização em ambientes de big data enfrenta desafios únicos devido à complexidade e variabilidade dos dados. Diferentemente dos conjuntos de dados tradicionais, os dados em big data são caracterizados por seu grande volume, variedade e velocidade, o que exige estratégias de otimização que podem lidar com essa complexidade. Por exemplo, a otimização de esquemas em bancos de dados NoSQL, que frequentemente armazenam dados semi-estruturados ou não estruturados, é mais desafiadora do que em bancos de dados relacionais com estruturas de dados bem definidas.

- Escalabilidade e Desempenho: Outro desafio significativo é garantir a escalabilidade e o desempenho dos sistemas. À medida que os volumes de dados aumentam, as estratégias de otimização devem ser capazes de escalar eficientemente. Isso inclui não apenas o escalonamento horizontal, adicionando mais máquinas ao cluster, mas também otimizando o uso de recursos em cada máquina. A otimização de consultas em sistemas distribuídos, como o Hadoop e o Spark, é particularmente desafiadora, pois requer a coordenação e o processamento eficiente de dados em vários nós.

- Equilíbrio entre Armazenamento e Acesso: Manter um equilíbrio entre armazenamento eficiente e acesso rápido aos dados é um desafio contínuo em big data. Técnicas como compressão de dados e particionamento devem ser cuidadosamente escolhidas para otimizar o armazenamento, sem prejudicar o desempenho das consultas. Além disso, a estratégia de indexação deve ser adaptada para equilibrar o custo de manutenção dos índices com os benefícios de velocidade de acesso.

- Manutenção e Evolução: A manutenção de sistemas otimizados em um ambiente de big data em constante evolução é desafiadora. Os esquemas de dados, as estratégias de indexação e as técnicas de otimização de consultas precisam ser continuamente avaliados e ajustados para atender às mudanças nas necessidades e padrões de acesso aos dados.

Conclusão e Leituras Futuras em Esquemas de Dados e Otimização de Consultas em Big Data

A seção sobre esquemas de dados e otimização de consultas em big data destaca a complexidade inerente ao gerenciamento de grandes volumes de dados. Enquanto os esquemas de dados fornecem uma estrutura essencial para o armazenamento e a recuperação eficientes, as técnicas de otimização de consultas são cruciais para garantir acessos rápidos e precisos a essas informações. Ambos são fundamentais em um mundo dominado por dados, onde a capacidade de processar e analisar informações rapidamente pode fornecer insights valiosos e vantagens competitivas.

Esta discussão sublinha a importância de uma abordagem balanceada que considere tanto a estruturação eficiente dos dados quanto as técnicas avançadas de consulta. O desafio é manter sistemas que sejam tanto flexíveis quanto capazes de lidar com a crescente escala e complexidade dos dados. Além disso, a evolução constante das tecnologias de big data exige uma adaptação contínua e aprendizado por parte dos profissionais da área.

Integração e Governança de Dados em Big Data

A integração de dados em big data envolve a consolidação de dados de diversas fontes e formatos em um sistema coeso. Este processo é desafiador devido à variedade e ao volume dos dados. Por exemplo, dados podem vir de sistemas internos como CRMs e ERPs, de dispositivos IoT, ou de fontes externas como redes sociais e serviços de nuvem. A integração eficaz requer abordagens robustas para lidar com essas diferenças, garantindo a consistência e a usabilidade dos dados.

Estratégias como ETL (Extract, Transform, Load), ELT (Extract, Load, Transform), e streaming de dados em tempo real são fundamentais. A escolha entre essas abordagens depende da natureza dos dados e dos requisitos de processamento. Por exemplo, o streaming é vital para dados em tempo real, como os gerados por sensores IoT, enquanto ETL é adequado para situações onde os dados podem ser pré-processados antes do uso.

Governança de Dados em Big Data

A governança de dados em ambientes de big data é um aspecto crítico que garante a qualidade, segurança e conformidade dos dados em larga escala. Em uma era onde os dados são um ativo valioso, a governança adequada é essencial para manter a confiança e a integridade dos dados, ao mesmo tempo em que se assegura a conformidade com as regulamentações globais.

A governança de dados abrange várias áreas, incluindo:

- Qualidade de Dados: Garantindo a precisão, a completude e a confiabilidade dos dados.

- Limpeza e Validação: Garantir que os dados sejam precisos e livres de erros.

- Padronização: Estabelecer normas para formatos de dados, garantindo consistência.

- Segurança e Privacidade: Implementando políticas de segurança robustas, gerenciamento de acesso e conformidade com regulamentos como GDPR e HIPAA.

- Proteção de Dados: Implementar medidas de segurança para proteger dados contra acessos não autorizados.

- Cumprimento de Normas: Adesão a regulamentos como GDPR, HIPAA, entre outros, que impõem diretrizes rigorosas sobre a gestão de dados pessoais e sensíveis.

- Gerenciamento do Ciclo de Vida dos Dados: Definindo políticas para a retenção, arquivamento e exclusão de dados.

- Políticas de Retenção: Definir quanto tempo os dados devem ser armazenados, com base em seu valor e relevância.

- Arquivamento e Exclusão: Estabelecer práticas para armazenar dados de longo prazo e para excluir dados de forma segura e conforme as regulamentações.

A governança em big data enfrenta desafios contemporâneos únicos, como lidar com o volume massivo e a variedade de fontes de dados. Além disso, as regulamentações em constante mudança exigem flexibilidade e adaptabilidade nas políticas de governança.

Como a área é muito dinâmica, ainda temos o impacto causado por inovações e tendências, tais como:

- Automatização da Governança: Utilização de IA e machine learning para automatizar aspectos da governança, como classificação de dados e monitoramento de conformidade.

- Governança como Serviço: A ascensão de soluções de governança baseadas em nuvem, oferecendo ferramentas e serviços para facilitar a gestão de dados.

A governança de dados em big data é um campo dinâmico, exigindo um compromisso contínuo com as melhores práticas e adaptação às novas tecnologias e regulamentações. Uma governança eficaz é vital para maximizar o valor dos dados e minimizar os riscos associados à sua gestão.

Desafios e Estratégias Futuras na Integração e Governança de Dados em Big Data

A integração e governança de dados em ambientes de big data continuam a enfrentar desafios significativos devido ao crescimento exponencial do volume de dados, à diversidade das fontes de dados e à evolução contínua das tecnologias e regulamentações. Estes desafios requerem estratégias inovadoras e adaptativas para garantir a eficácia na gestão de dados.

Os Principais Desafios na Integração de Dados são

- Diversidade de Fontes e Formatos: Com a proliferação de fontes de dados, desde dispositivos IoT até plataformas de mídia social, a integração eficaz requer sistemas capazes de processar uma variedade de formatos de dados.

- Latência e Tempo Real: Em muitos casos, como na análise de dados de streaming, a latência baixa é crucial, exigindo métodos de integração que possam processar dados em tempo real.

Além disso, também temos alguns importantes Desafios na Governança de Dados:

- Regulamentações em Mudança: Manter a conformidade com regulamentações globais em constante evolução, como GDPR, é um desafio contínuo.

- Segurança e Privacidade: Proteger dados sensíveis e pessoais contra violações, enquanto se mantém a acessibilidade necessária para análises e operações de negócios.

E claro, podemos citar alguma Estratégias Futuras para Superar os Desafios:

- Automatização e IA: O uso de inteligência artificial e automação para melhorar a integração e a governança de dados. Por exemplo, algoritmos de IA podem ser usados para classificar dados automaticamente e monitorar a conformidade.

- Tecnologias Emergentes: Explorar tecnologias emergentes, como blockchain para segurança de dados e computação em nuvem para escalabilidade, pode oferecer novas soluções para desafios antigos.

- Flexibilidade e Adaptação: Desenvolver sistemas flexíveis que possam se adaptar rapidamente às mudanças nas necessidades de negócios e regulamentações.

Os desafios na integração e governança de dados em big data são vastos e complexos, mas com estratégias inovadoras e a adoção de novas tecnologias, é possível superá-los. O futuro exige uma abordagem mais dinâmica e adaptativa para a gestão de dados em larga escala.

Conclusão e Leituras Futuras em Integração e Governança de Dados em Big Data

A integração e governança de dados em big data representam pilares fundamentais para o sucesso de sistemas de informação modernos. A integração eficaz assegura que dados de fontes diversificadas e em formatos variados sejam unificados e acessíveis, enquanto a governança adequada garante que esses dados sejam geridos de forma responsável, segura e conforme as regulamentações vigentes.

Diante do cenário atual de big data, marcado por volumes crescentes de dados e evoluções tecnológicas rápidas, a integração e a governança de dados tornam-se cada vez mais complexas e vitais. Estas áreas não apenas facilitam a extração de insights valiosos dos dados, mas também asseguram a confiança e a integridade das informações. Portanto, a capacidade de adaptar-se a novas tendências e desafios é essencial para qualquer profissional que trabalhe com big data.

Análise Avançada e Visualização de Dados em Big Data

A análise avançada em big data envolve mais do que simplesmente processar grandes volumes de dados. Ela incorpora técnicas sofisticadas e algoritmos para extrair insights significativos que podem informar decisões críticas de negócios e inovações científicas.

Esta seção explora como técnicas analíticas, desde a estatística básica até algoritmos de aprendizado de máquina, são aplicadas em big data para descobrir padrões, tendências e correlações.

Técnicas de Análise Avançada:

- Machine Learning e IA: Utilização de aprendizado de máquina para identificar padrões e prever tendências. Algoritmos de deep learning são particularmente úteis para dados não estruturados, como imagens e texto.

- Análise Preditiva: Emprega modelos estatísticos e de machine learning para fazer previsões sobre eventos futuros baseados em dados históricos.

- Mineração de Dados: Explora grandes conjuntos de dados para encontrar padrões ocultos e relações desconhecidas, proporcionando insights valiosos.

Visualizações eficazes são essenciais para interpretar os resultados complexos da análise de big data. Elas transformam dados brutos em informações compreensíveis e acionáveis, facilitando a comunicação e a compreensão dos insights.

Estratégias de Visualização:

- Ferramentas e Técnicas: Utilização de ferramentas como Tableau, Qlik e D3.js para criar visualizações impactantes. Técnicas como mapas de calor, gráficos de dispersão e visualizações interativas são essenciais para apresentar dados complexos de forma intuitiva.

- Narrativa de Dados: Integrar visualizações de dados em uma narrativa coerente que conta uma história, ajudando na interpretação e no engajamento do público.

Os principais desafios na análise avançada e visualização de dados incluem lidar com a vasta quantidade e variedade de dados, garantir a precisão e a relevância das análises, e desenvolver visualizações que sejam tanto informativas quanto acessíveis.

Futuro da Análise e Visualização em Big Data:

- Tecnologias Emergentes: Exploração de realidade aumentada e virtual para criar visualizações imersivas.

- Integração com IA: Automatização da análise de dados e criação de visualizações usando inteligência artificial.

Visualização de Dados em Big Data

No contexto de big data, a visualização de dados transcende a mera representação gráfica de números. Ela é uma ferramenta essencial para a comunicação eficaz de complexidades inerentes aos grandes volumes de dados. Com o volume e a velocidade dos dados em constante aumento, visualizações bem projetadas podem revelar tendências ocultas, padrões e insights que poderiam permanecer obscuros em análises textuais ou numéricas convencionais.

Técnicas e Ferramentas de Visualização

- Ferramentas Modernas: Ferramentas como Tableau, Power BI, e D3.js permitem a criação de visualizações interativas e detalhadas. Essas ferramentas são capazes de lidar com grandes volumes de dados e oferecem flexibilidade para criar uma variedade de tipos de gráficos, desde básicos até os mais complexos.

- Design e Interatividade: O design de visualização é crucial. Uma boa visualização deve ser intuitiva, informativa e adaptada ao público-alvo. A interatividade, como filtros e a capacidade de explorar diferentes aspectos dos dados, enriquece a experiência do usuário, permitindo uma exploração mais profunda dos dados.

Desafios na Visualização de Big Data:

- Volume e Complexidade: O principal desafio na visualização de big data é representar grandes volumes de dados de maneira clara e compreensível. Além disso, a complexidade dos dados, especialmente quando não estruturados, exige abordagens criativas de visualização.

- Atualização em Tempo Real: Com a crescente demanda por análises em tempo real, as visualizações também precisam ser capazes de se atualizar dinamicamente, refletindo as mudanças nos dados quase instantaneamente.

Futuro da Visualização de Dados:

- Realidade Aumentada e Virtual: A integração de tecnologias de realidade aumentada (AR) e virtual (VR) na visualização de dados promete criar experiências mais imersivas e interativas.

- Automatização com IA: A aplicação de IA para gerar automaticamente visualizações de dados eficazes, personalizadas conforme as necessidades do usuário.

Desafios e Inovações na Análise e Visualização de Big Data

Um dos principais desafios na análise de big data é lidar com a sua enorme complexidade e volume. Extrair insights significativos de conjuntos de dados cada vez maiores e mais variados requer algoritmos avançados e capacidade computacional robusta. Além disso, a heterogeneidade dos dados, que muitas vezes inclui dados não estruturados como texto, imagem e vídeo, aumenta a complexidade da análise.

Outro desafio significativo é a necessidade de processamento em tempo real ou quase real. Com a crescente demanda por tomada de decisão rápida baseada em dados, as ferramentas e técnicas de análise precisam ser capazes de processar e analisar dados em alta velocidade.

A aplicação de IA e machine learning tem sido uma das inovações mais impactantes na análise de big data. Estas tecnologias permitem não apenas a automação de processos analíticos complexos, mas também a geração de insights mais profundos e a previsão de tendências futuras com maior precisão.

Além da análise descritiva tradicional, há um aumento no uso da análise preditiva e prescritiva. Enquanto a análise preditiva se concentra em prever o que pode acontecer, a análise prescritiva sugere ações que podem ser tomadas para influenciar esses resultados.

Visualizar grandes volumes de dados complexos de maneira eficaz e intuitiva é um desafio constante. As visualizações devem ser capazes de representar não apenas a magnitude, mas também as nuances e a multidimensionalidade dos dados.

As visualizações precisam ser não apenas informativas, mas também interativas, permitindo aos usuários explorar os dados de maneira mais profunda. Além disso, elas devem ser escaláveis para acomodar o crescimento contínuo dos volumes de dados.

Uma área emergente é o uso de realidade aumentada (AR) e virtual (VR) para visualização de dados. Estas tecnologias oferecem novas formas de interagir e imergir nos dados, proporcionando experiências mais ricas e insights mais profundos.

A integração da IA na criação de visualizações de dados está possibilitando a geração automatizada de visualizações baseadas em características específicas dos dados, melhorando a eficiência e a relevância das representações visuais.

Arquiteturas de Referência e Casos de Uso em Big Data

Arquiteturas de referência em big data são estruturas projetadas para orientar a construção de sistemas de dados robustos, escaláveis e eficientes. Estas arquiteturas fornecem um conjunto de práticas recomendadas, padrões e modelos que guiam a construção de sistemas para o gerenciamento e análise de grandes volumes de dados. A complexidade e diversidade dos dados em big data tornam essas arquiteturas o melhor caminho para criar soluções eficientes, escaláveis e seguras.

As principais características das Arquiteturas de Big Data são:

- Escalabilidade: Capacidade de lidar com o aumento exponencial de dados, seja através de escalabilidade horizontal (adicionando mais nós) ou vertical (aumentando a capacidade de um nó existente).

- Flexibilidade: Adaptação às mudanças rápidas em requisitos de negócios e tecnologia, permitindo a integração de novas fontes de dados e a evolução das análises.

- Resiliência e Tolerância a Falhas: Garantia de operação contínua e integridade de dados mesmo diante de falhas e interrupções.

Seus componentes essenciais:

- Sistemas de Armazenamento: Uso de sistemas de arquivos distribuídos, como Hadoop Distributed File System (HDFS), e soluções de armazenamento baseadas em nuvem.

- Processamento de Dados: Emprego de frameworks de processamento, como Apache Hadoop para processamento em lote e Apache Spark para processamento em tempo real.

- Gestão e Integração de Dados: Técnicas de ETL, ferramentas de ingestão de dados e sistemas para gerenciamento de metadados.

Requisitos comuns para sistemas de Big Data

Antes de começarmos a pensar em como arquitetar e construir esses sistemas que são capazes de processar grandes volumes de dados, vamos formalizar seus requisitos.

Os requisitos comuns que gostaríamos de ver na maioria dos sistemas são:

- Tolerância a falhas (em caso de falhas no servidor e problemas de conectividade de rede)

- Baixa latência de consulta e tempos de resposta

- Baixa latência e desatualização de dados (staleness) — propagação rápida de atualizações (quão obsoletos os dados podem estar quando consultados)

- Consistência dos dados

- Cobertura de dados históricos — capacidade de consultar todos os dados históricos coletados até agora

- Escalabilidade horizontal (capacidade de adicionar mais servidores)

- Extensível — permitir consultas ad-hoc

- Manutenção mínima

- Baixo custo (naturalmente)

Porém, nem todo tipo de sistema de big data é capaz de cumpri-los tão bem quanto veremos em breve.

4 Tipos de Sistemas

Sistema de consultas em tempo real + ad-hoc

O primeiro tipo é em tempo real para um intervalo limitado e consultas ad-hoc. Estes são sistemas que podem responder a quaisquer perguntas ad-hoc sobre os dados recebidos durante alguma pequena janela de tempo recente. Exemplos seriam alertas ou detecção de fraudes.

A desvantagem disso seria a consistência dos dados e o acesso a dados históricos.

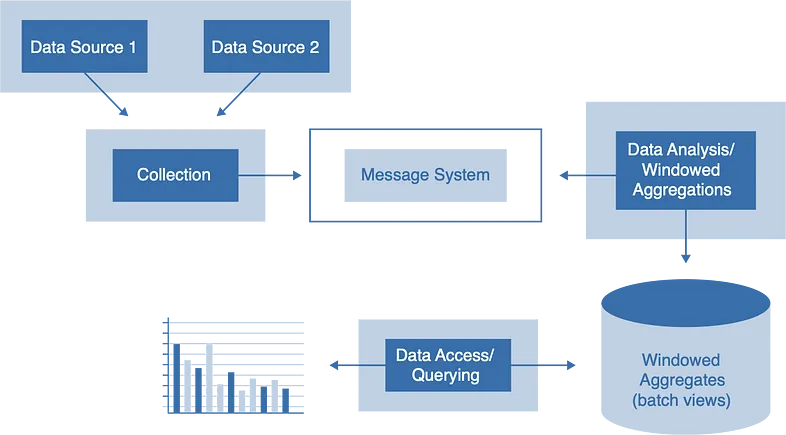

Histórico completo + Tempo real + Predefinido

O segundo tipo é histórico completo, consultas limitadas em tempo real e pré-definidas. Esses sistemas permitem que você faça perguntas com base nos pontos de dados históricos pré-calculados (também conhecidos como métricas), mas não em dados brutos.

A desvantagem disso seria não ter acesso a dados brutos históricos (apenas métricas) e não ter consultas ad-hoc.

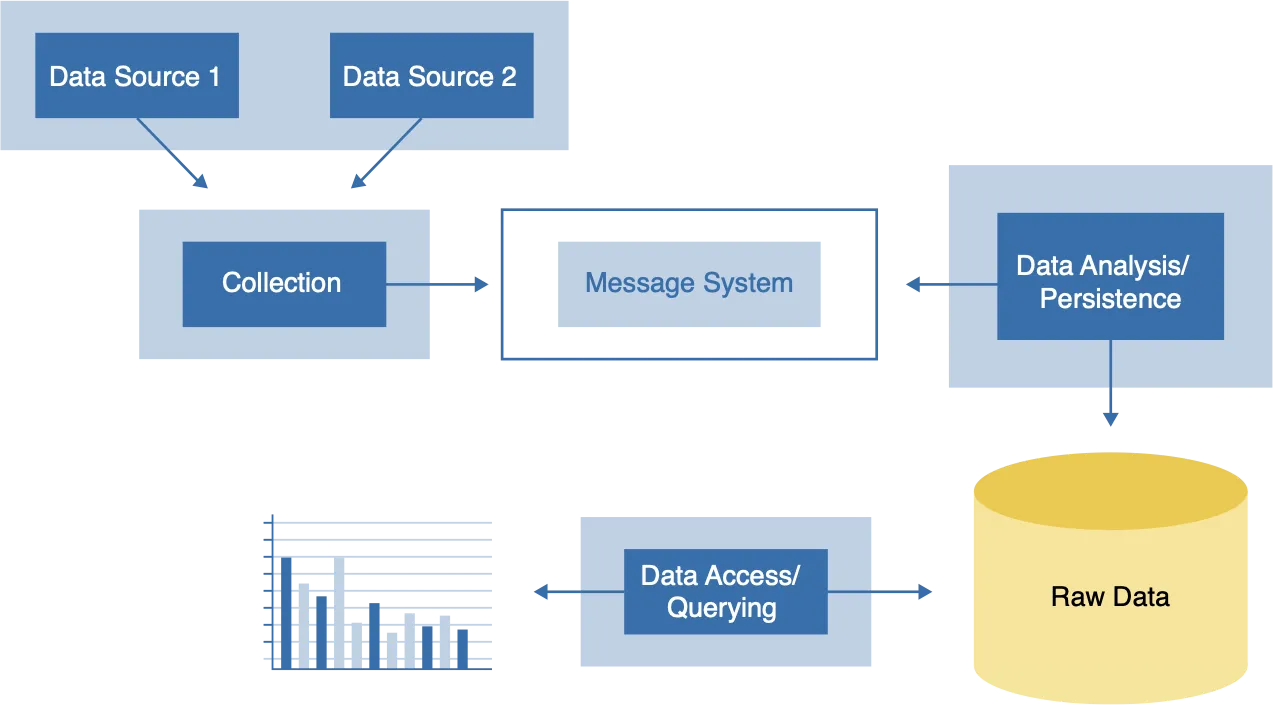

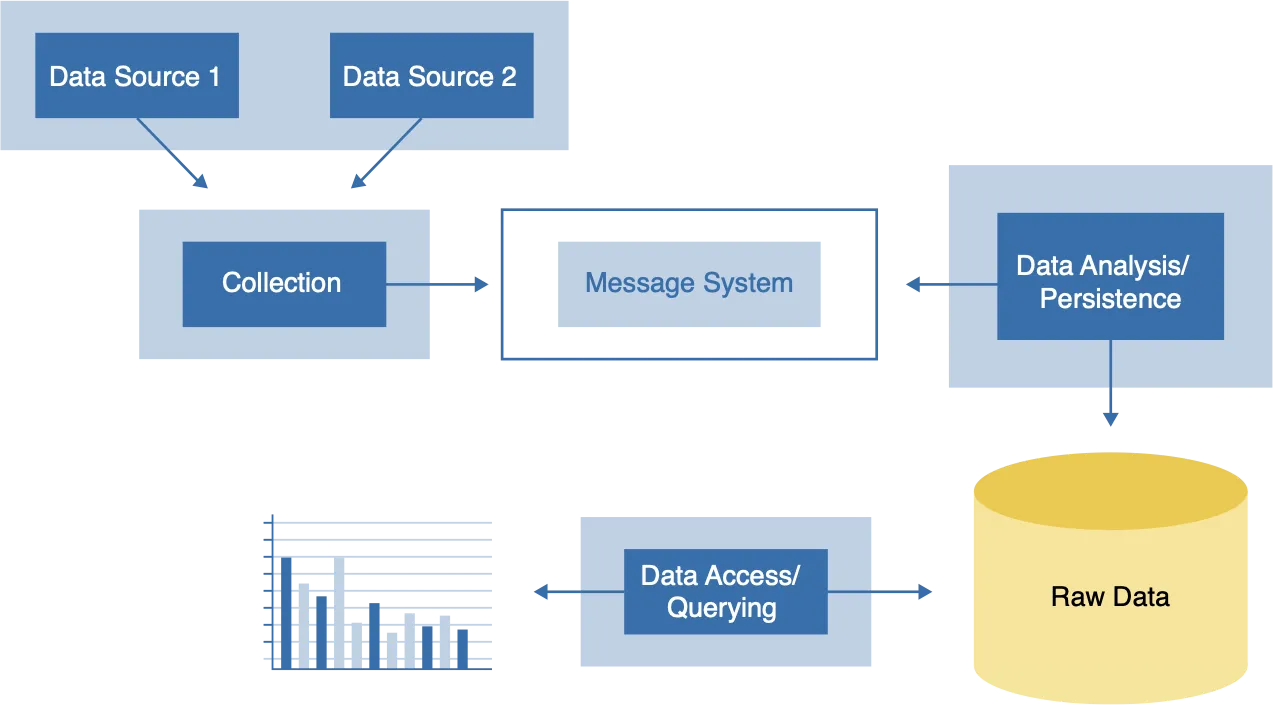

Histórico completo + consultas ad-hoc + Sem tempo real

O terceiro tipo é histórico completo, sem consultas em tempo real e ad-hoc. Esses sistemas permitem que você faça qualquer pergunta (consulta ad-hoc) usando pontos de dados brutos armazenados, sobre todo o conjunto de dados armazenados, mas sem dados atualizados em tempo real. Semelhante aos aplicativos de banco de dados tradicionais, onde você pode executar consultas como: “Encontre todos os eventos de encontro que mencionam programação python na área de Nova York”.

A desvantagem seria o baixo tempo de resposta da consulta e a baixa latência de dados, levando a consultas obsoletas.

Esse sistema é conhecido como um sistema somente em lote.

Histórico completo +Ad-Hoc + Tempo Real

O quarto tipo são consultas históricas, completas em tempo real e ad-hoc. Esses sistemas podem responder a qualquer pergunta com base em todos os dados coletados até agora. Seria como o sistema anterior, mas os resultados têm que incluir dados atualizados.

A grande diferença entre um sistema somente em lote é que as consultas não são obsoletas, elas incluem dados históricos e em tempo real.

Estes exigem alta manutenção e serão o foco deste curso. A implementação mais comum é a arquitetura Lambda.

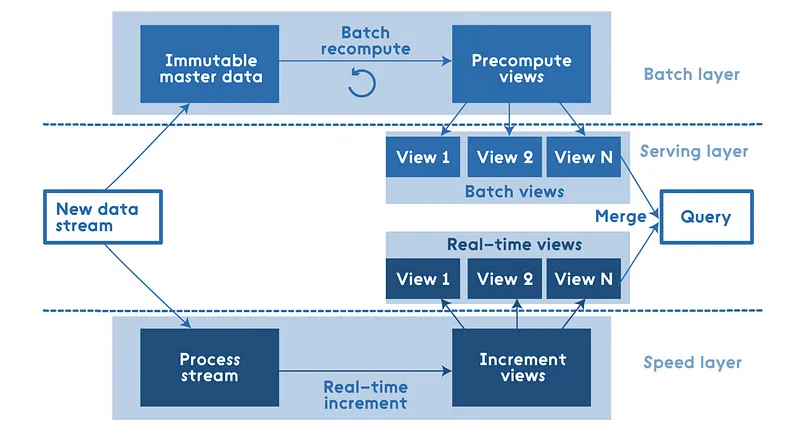

Arquitetura Lambda

A arquitetura do Lambda é formalmente definida como uma abordagem de propósito geral para implementar uma função arbitrária em um conjunto de dados arbitrário e fazer com que a função retorne seus resultados com baixa latência.

Ele resolve o problema de calcular funções arbitrárias em dados arbitrários em tempo real, decompondo o problema em 3 camadas: a camada de lote, a camada de serviço e a camada de velocidade.

A camada em lote geralmente é um sistema de data lake como o Hadoop. Este arquivo histórico é usado para armazenar todos os dados já coletados. A camada de lote oferece suporte a consultas em lote, o processamento em lote é usado para gerar análises, predefinidas ou ad-hoc.

A camada de velocidade é definida como uma combinação de enfileiramento, streaming e armazenamentos de dados operacionais. A análise dessa camada pode ser baseada em dados com apenas 1 hora de idade. Portanto, ele é responsável por dados que têm de 0 a 1 hora de idade.

A camada de serviço é responsável por servir os resultados combinando a saída da camada de velocidade e batelada.

Para resumir, o Lambda define uma arquitetura de big data que permite consultas e cálculos arbitrários tanto em dados de movimentação rápida quanto em dados históricos.

Adicionalmente, implementar uma arquitetura de referência em big data envolve desafios como a escolha das tecnologias apropriadas, o alinhamento com os objetivos de negócios e a garantia de conformidade com as regulamentações de dados. Além disso, enfrenta-se o desafio de manter a arquitetura flexível e adaptável às tendências emergentes.

O futuro das arquiteturas de big data inclui uma maior integração com tecnologias de IA e machine learning, adoção crescente de soluções baseadas em nuvem e uma atenção contínua às questões de segurança e privacidade de dados.

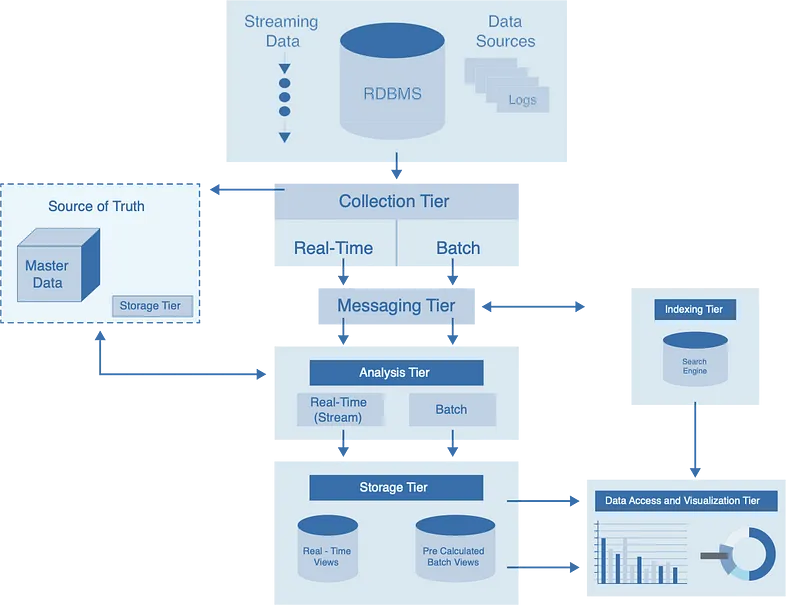

The Big Picture

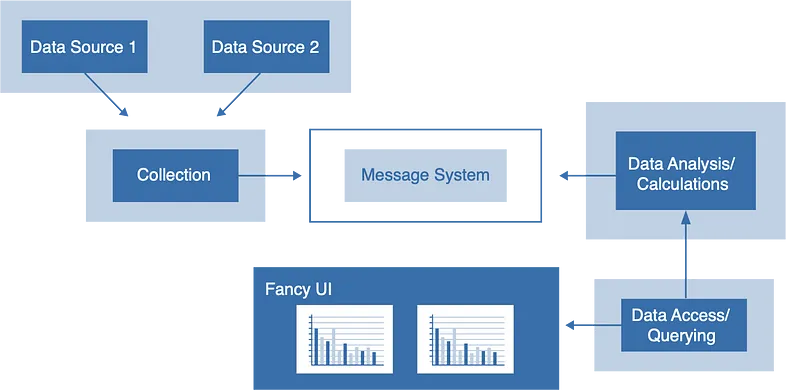

Vamos seguir um plano arquitetônico que nos permite falar sobre todos os sistemas de Big Data de forma genérica. Nossa arquitetura é dividida em diferentes camadas, tenha em mente que essas não são camadas rígidas rígidas que seu projeto precisa se encaixar. É um modelo genérico onde a pilha de componentes (blocos de construção) pode ser classificada por funcionalidade. Essa estrutura é um modelo para pipelines de dados de projeto com diferentes requisitos: como sistemas de streaming com recursos analíticos on-line ou sistemas em lote com requisitos analíticos off-line.

- Camada de Coleta – Essa camada é onde os dados entram no sistema e iniciam sua jornada; A partir daqui, ele progredirá pelo resto do pipeline de dados do sistema.

- Camada de mensagens – Com essa camada, separamos os componentes da camada de coleção de nossa camada de análise, onde os recursos analíticos podem começar.

- Camada de análise – Nesta camada, roteamos os dados para destinos diferentes, classificamos os fluxos de dados e é o primeiro ponto onde a análise pode ocorrer.

- Nível de armazenamento – Essa é a camada em que o pipeline de dados é persistido para acesso a dados de ferramentas de consulta ou analíticas.

- Camada de indexação – Onde os dados são analisados e indexados, o que permite opções de consulta mais rápidas e dinâmicas.

- Camada de visualização – A camada de visualização, ou camada de apresentação, provavelmente a camada mais importante, onde os usuários do pipeline de dados podem sentir o VALOR de DADOS.

Preocupações comuns

Aqui está uma lista das preocupações que são comuns a muitos dos estágios do pipeline de processamento. Eles se assemelham muito aos nossos requisitos para sistemas de Big Data.

- Escalabilidade

- Tolerância a falhas / disponibilidade

- Consistência dos dados

- Latência de dados (obsolescência)

- Tempos de resposta da consulta

E, claro, custo, mas isso é óbvio

Desafios e Inovações nas Arquiteturas de Big Data

As arquiteturas de big data enfrentam desafios únicos, impulsionados pelo crescimento exponencial dos volumes de dados e pela rápida evolução das tecnologias. Compreender esses desafios é crucial para desenvolver arquiteturas robustas e adaptáveis que possam suportar as demandas atuais e futuras de processamento e análise de dados.

- Escalar com Eficiência: Um dos principais desafios é projetar sistemas que possam escalar eficientemente para lidar com volumes crescentes de dados, mantendo um desempenho ótimo.

- Flexibilidade Arquitetônica: As arquiteturas devem ser flexíveis o suficiente para se adaptar a novas fontes de dados, formatos e requisitos de processamento.

- Segurança de Dados: Com o aumento de violações de dados, garantir a segurança e a integridade dos dados tornou-se um desafio significativo.

- Conformidade Regulatória: Manter a conformidade com regulamentações em constante mudança, como GDPR, é essencial.

Para superar esses desafios, as arquiteturas de big data estão evoluindo com a adoção de novas tecnologias e práticas.

Tecnologias Emergentes:

- Cloud Computing e Arquiteturas Híbridas: O uso de cloud computing e soluções híbridas oferece maior escalabilidade, flexibilidade e eficiência de custos.

- Automação e IA: A integração de IA e automação está otimizando várias operações, desde a ingestão de dados até análises complexas.

Abordagens Modernas:

- Arquiteturas Baseadas em Microserviços: Arquiteturas baseadas em microserviços proporcionam modularidade, permitindo uma manutenção e escalabilidade mais eficientes.

- Data Lakes e Data Mesh: A adoção de data lakes e data mesh facilita o gerenciamento de dados em grande escala, melhorando o acesso e a análise.

As arquiteturas de big data estão em constante evolução para enfrentar desafios de escalabilidade, segurança e conformidade. As inovações atuais e futuras nessas arquiteturas visam não apenas resolver os problemas existentes, mas também abrir novos caminhos para o aproveitamento eficaz do big data.

Conclusão e Leituras Futuras em Arquiteturas de Referência e Casos de Uso em Big Data

A seção sobre arquiteturas de referência e casos de uso em big data oferece uma visão abrangente de como os conceitos teóricos e práticos de big data são aplicados em diversas situações reais. As arquiteturas de referência fornecem um guia para construir sistemas eficientes e adaptáveis, enquanto os casos de uso ilustram a aplicação prática dessas arquiteturas em diferentes setores.

O estudo das arquiteturas de referência e casos de uso em big data destaca a profundidade e a amplitude do impacto que o big data tem no mundo contemporâneo. De negócios a saúde, de finanças a sustentabilidade, o big data está remodelando como interagimos com o mundo e tomamos decisões fundamentais.

Os desafios relacionados à escalabilidade, segurança, privacidade e integração permanecem no centro das preocupações no campo do big data. Ao mesmo tempo, inovações em cloud computing, IA e aprendizado de máquina continuam a evoluir, oferecendo novas oportunidades para superar esses desafios e aprimorar a eficácia das arquiteturas de big data.

Tendências Futuras e Inovações em Big Data

A esfera do big data está passando por uma constante evolução, impulsionada pela rápida progressão tecnológica e pelas mudanças nas demandas empresariais e sociais. Esta subseção introduz as principais tendências e inovações emergentes que estão moldando o futuro do big data, destacando sua importância estratégica e operacional.

Principais Áreas de Evolução:

- Integração de Tecnologias Avançadas: O big data está cada vez mais entrelaçado com tecnologias emergentes como IA, machine learning e Internet das Coisas (IoT). A convergência dessas tecnologias está abrindo novos horizontes para análises mais profundas e aplicações inovadoras.

- Adaptação às Necessidades em Tempo Real: Com a aceleração da geração de dados, as arquiteturas de big data estão evoluindo para processar e analisar dados em tempo real, permitindo respostas mais rápidas e decisões mais informadas.

Desafios Contemporâneos:

- Gerenciamento de Dados em Escala: À medida que o volume de dados continua crescendo, o desafio de gerenciar e processar esses dados de maneira eficiente se torna mais premente.

- Segurança e Privacidade: A segurança dos dados e as preocupações com a privacidade estão no centro das discussões, exigindo soluções inovadoras para proteger informações sensíveis e cumprir com regulamentações rigorosas.

Este panorama das evoluções emergentes em big data não apenas delineia o cenário atual, mas também projeta as transformações futuras. Compreender estas tendências é essencial para qualquer profissional ou entidade que busca se manter relevante e competitiva na era do big data.

Avanços Tecnológicos em Big Data

O campo de big data está em constante evolução, com avanços tecnológicos que continuam a remodelar as capacidades e possibilidades de análise e processamento de dados em larga escala. Esta subseção explora algumas das inovações mais significativas e como elas estão influenciando o cenário de big data.

Tecnologias Emergentes e Seu Impacto:

- Computação em Nuvem e Edge Computing

- Expansão da Computação em Nuvem: A nuvem se tornou um componente integral das arquiteturas de big data, proporcionando escalabilidade, flexibilidade e eficiência de custos. Soluções como Amazon Web Services, Google Cloud Platform e Microsoft Azure estão na vanguarda, oferecendo serviços avançados de armazenamento e processamento.

- Crescente Importância do Edge Computing: Com o aumento dos dispositivos IoT, o edge computing ganha destaque, processando dados mais próximos à fonte, o que diminui a latência e reduz a necessidade de largura de banda para transferência de dados massivos.

- Inteligência Artificial e Machine Learning

- Integração Profunda com IA: A integração de IA em sistemas de big data está automatizando e aprimorando processos de análise, desde a identificação de padrões até a previsão de tendências futuras. Algoritmos de deep learning, em particular, estão transformando a análise de dados não estruturados.

- Aplicações Preditivas e Prescritivas: A IA não apenas ajuda na análise preditiva, mas também avança para recomendações prescritivas, sugerindo ações baseadas em insights de dados.

Enquanto esses avanços oferecem oportunidades significativas, eles também apresentam desafios como a necessidade de novas habilidades e a complexidade no gerenciamento de infraestruturas de dados híbridas. Além disso, questões de segurança de dados e privacidade permanecem como preocupações primordiais.

Os avanços tecnológicos em big data estão abrindo novas fronteiras, permitindo que organizações de todos os tamanhos aproveitem o poder dos dados para inovação e vantagem competitiva. Acompanhar essas tendências é essencial para qualquer profissional que deseje permanecer relevante na era do big data.

Impacto Social e Empresarial das Tendências e Inovações em Big Data

Big data não é apenas um fenômeno tecnológico; é um motor de transformação social e empresarial. As inovações e tendências em big data estão remodelando a maneira como as empresas operam e como as sociedades funcionam, trazendo tanto oportunidades quanto desafios significativos.

No Mundo dos Negócios:

- Inovação e Competitividade: As empresas estão utilizando big data para inovar em produtos e serviços, personalizar a experiência do cliente e otimizar operações. Isso resulta em uma vantagem competitiva significativa em um mercado cada vez mais orientado por dados.

- Análise de Comportamento do Consumidor: O big data permite uma compreensão mais profunda do comportamento do consumidor, levando a estratégias de marketing mais eficazes e ao desenvolvimento de produtos mais alinhados com as necessidades dos clientes.

- Otimização da Cadeia de Suprimentos: Empresas estão usando big data para tornar suas cadeias de suprimentos mais eficientes e responsivas, reduzindo custos e melhorando a satisfação do cliente.

Impacto Social:

- Saúde Pública e Medicina Personalizada: No setor de saúde, o big data está impulsionando avanços na medicina personalizada e na gestão de surtos de doenças, contribuindo para sistemas de saúde mais eficientes e personalizados.

- Planejamento Urbano e Cidades Inteligentes: Big data está no centro do desenvolvimento de cidades inteligentes, ajudando no planejamento urbano, na gestão de tráfego e na sustentabilidade.

Desafios e Responsabilidades:

- Ética e Privacidade: Com o aumento do uso de big data, surgem preocupações significativas sobre a privacidade e a ética na coleta e análise de dados.

- Desigualdade Digital: Existe o risco de que o big data amplie a desigualdade digital, beneficiando principalmente aqueles com acesso a tecnologias e habilidades de dados.

As tendências e inovações em big data estão desencadeando mudanças profundas no tecido social e empresarial. Compreender essas transformações é crucial para navegar no presente e moldar o futuro de maneira responsável e ética.

Desafios Futuros e Estratégias de Resolução em Big Data

À medida que o big data continua a evoluir, surgem novos desafios que exigem soluções inovadoras e estratégias adaptativas. Esta subseção explora os principais desafios futuros no campo do big data e discute as estratégias potenciais para sua resolução.

Principais Desafios em Big Data:

- Escalabilidade e Gerenciamento de Dados

- Gerenciamento de Volumes Crescentes: Um dos maiores desafios é gerenciar o volume crescente de dados. As soluções devem não apenas armazenar grandes quantidades de dados, mas também permitir acesso e análise rápidos e eficientes.

- Estratégias de Escalabilidade: A adoção de arquiteturas escaláveis e flexíveis, como soluções baseadas em nuvem e microserviços, pode ajudar a lidar com o crescimento dos dados.

- Segurança e Privacidade

- Proteção de Dados Sensíveis: Com o aumento das violações de dados, a segurança torna-se uma preocupação crescente. A implementação de protocolos de segurança robustos e a criptografia de dados são fundamentais.

- Conformidade com Regulamentações: As organizações devem estar atentas às leis de privacidade de dados, como GDPR, adaptando suas práticas para manter a conformidade.

- Estratégias de Inovação

- Automatização do Processamento de Dados: A utilização de IA e automação para processar e analisar grandes conjuntos de dados pode aumentar a eficiência e reduzir erros humanos.

- IA na Governança de Dados: A IA também pode ser usada para melhorar a governança de dados, automatizando a conformidade e monitorando a integridade dos dados.

- Sustentabilidade em Big Data

- Eficiência Energética: Com o crescimento dos data centers, a eficiência energética tornou-se uma preocupação. Estratégias como o uso de energia renovável e a otimização do resfriamento dos data centers são essenciais para uma abordagem mais sustentável.

Os desafios futuros em big data são complexos e multifacetados, mas com estratégias inovadoras e uma abordagem proativa, é possível navegar neste campo em constante evolução. A chave é a adaptação contínua às novas tecnologias e tendências, garantindo ao mesmo tempo a segurança, privacidade e sustentabilidade.

Conclusão e Leituras Futuras em Tendências Futuras e Inovações em Big Data

À medida que nos aprofundamos nas tendências futuras e inovações em big data, torna-se evidente que estamos entrando em uma era onde a capacidade de gerenciar, analisar e extrair valor dos dados não é apenas uma vantagem competitiva, mas uma necessidade crucial em várias esferas. O big data está se tornando o núcleo de estratégias inovadoras em negócios, ciência, tecnologia e políticas sociais.

Tendências Emergentes.

- Interconexão de Tecnologias: A convergência de big data com IA, machine learning, IoT e computação em nuvem está criando ecossistemas de dados mais inteligentes e interconectados.

- Democratização do Acesso a Dados: Há uma tendência crescente para tornar os dados mais acessíveis e compreensíveis, permitindo que um público mais amplo participe da economia baseada em dados.

Desafios Futuros.

- Escalabilidade e Sustentabilidade: Como os volumes de dados continuam a crescer, encontrar soluções que sejam escaláveis e sustentáveis permanecerá um desafio significativo.

- Ética e Privacidade: A ética na utilização de big data e a proteção da privacidade dos indivíduos são questões que exigirão atenção contínua e soluções inovadoras.

Conclusão e Estudos Futuros

A jornada através do artigo “Modelagem e Design de Dados para Arquiteturas de Software em Big Data” revela um panorama abrangente das complexidades, desafios e oportunidades inerentes ao big data. Desde a modelagem e design de dados até as arquiteturas de software, este artigo abordou aspectos críticos como escalabilidade, desempenho, integração de dados, governança e visualização, além de explorar as tendências futuras e inovações que estão moldando o campo.

As discussões e análises apresentadas destacam a importância de uma evolução contínua no campo do big data. À medida que a tecnologia avança e os volumes de dados crescem exponencialmente, profissionais e organizações devem se adaptar constantemente para explorar ao máximo o potencial dos dados.

Como desafios Futuros, em resumo, podemos destacar:

- Gerenciamento de Dados em Escala: O desafio de gerenciar eficientemente volumes massivos de dados permanecerá preeminente.

- Segurança e Ética: Questões de segurança, privacidade e ética no uso de big data continuarão a ser de suma importância, exigindo soluções inovadoras e abordagens responsáveis.

As Áreas de Estudo e Pesquisa Futuras que devemos manter em nosso radar:

- Integração com IA e ML: Aprofundar o estudo sobre como a IA e o machine learning podem ser mais efetivamente integrados nas arquiteturas de big data para análises mais precisas e automatizadas.

- Sustentabilidade em Big Data: Explorar estratégias para tornar as arquiteturas de big data mais sustentáveis, focando em eficiência energética e redução de impacto ambiental.

Leituras Futuras

- “Advanced Analytics with Spark” por Sandy Ryza et al. – Ideal para compreender análises avançadas em plataformas de processamento como Apache Spark.

- “Applied Data Science: Lessons Learned for the Data-Driven Business” por Martin Braschler et al. – Discute a aplicação prática da ciência de dados em ambientes empresariais.

- “Architecting Data Lakes” por Ben Sharma – Aborda o design e a implementação de lagos de dados, um componente-chave das arquiteturas de big data.

- “Artificial Intelligence in Practice” por Bernard Marr – Explora como a IA está sendo usada em conjunto com big data em várias indústrias.

- “Big Data: A Revolution That Will Transform How We Live, Work, and Think” por Viktor Mayer-Schönberger e Kenneth Cukier – Uma visão geral dos desafios e oportunidades apresentados pelo big data.

- “Big Data Analytics: From Strategic Planning to Enterprise Integration with Tools, Techniques, NoSQL, and Graph” por David Loshin – Explora técnicas e ferramentas para análise de big data.

- “Big Data: A Revolution That Will Transform How We Live, Work, and Think” por Viktor Mayer-Schönberger e Kenneth Cukier – Oferece uma visão geral dos impactos do big data em diferentes setores.

- “Big Data at Work: Dispelling the Myths, Uncovering the Opportunities” por Thomas H. Davenport – Um exame detalhado de como o big data está sendo usado no mundo dos negócios.

- “Big Data Management” por Fausto Pedro García Márquez e Benjamin Lev – Um livro que aborda as tendências atuais e futuras na gestão de big data.

- “Big Data: Principles and Best Practices of Scalable Realtime Data Systems” por Nathan Marz e James Warren – Fornece insights sobre sistemas de big data em tempo real e escaláveis.

- “Big Data: Principles and Paradigms” editado por Rajkumar Buyya e Rodrigo Calheiros – Apresenta os fundamentos de big data, com uma discussão sobre a integração e a governança de dados em sistemas de grande escala.

- “Big Data: Techniques and Technologies in Geoinformatics” por Hassan A. Karimi – Oferece uma visão sobre como o big data está remodelando o campo da geoinformática.

- “Cloud Data Centers and Cost Modeling” por Caesar Wu e Rajkumar Buyya – Fornece uma perspectiva sobre a modelagem de custos e a arquitetura de centros de dados em nuvem para big data.

- “Cloud Native Data-Center Networking” por Dinesh G. Dutt – Explora as abordagens de rede em arquiteturas de dados modernas e baseadas na nuvem.

- “Database Performance Tuning and Optimization” por Sitansu S. Mittra – Oferece uma visão abrangente sobre a otimização de desempenho em bancos de dados.

- “Data and Goliath: The Hidden Battles to Collect Your Data and Control Your World” por Bruce Schneier – Uma discussão sobre as implicações do big data na privacidade e vigilância.

- “Data Governance: How to Design, Deploy and Sustain an Effective Data Governance Program” por John Ladley – Um guia completo sobre a implementação eficaz de programas de governança de dados.

- “Data-Intensive Text Processing with MapReduce” por Jimmy Lin e Chris Dyer – Um guia prático sobre o processamento de textos em larga escala usando MapReduce, útil para entender o processamento de dados em big data.

- “Data Integration Blueprint and Modeling: Techniques for a Scalable and Sustainable Architecture” por Anthony David Giordano – Explora técnicas de integração de dados e modelagem, enfatizando arquiteturas escaláveis e sustentáveis.

- “Data Points: Visualization That Means Something” por Nathan Yau – Explora como transformar dados em visualizações significativas.

- “Data Science for Business” por Foster Provost e Tom Fawcett – Explora as aplicações práticas da ciência de dados nos negócios, com ênfase em técnicas de modelagem e análise de dados.

- “Data Science for Dummies” por Lillian Pierson – Uma introdução acessível às técnicas de ciência de dados, incluindo análise e visualização.

- “Designing Distributed Systems” por Brendan Burns – Oferece padrões e práticas para a construção de sistemas distribuídos escaláveis.

- “Distributed Systems for Fun and Profit” por Mikito Takada – Um livro que explora os fundamentos dos sistemas distribuídos, crucial para entender a escalabilidade em ambientes de big data.

- “Ethics of Big Data: Balancing Risk and Innovation” por Kord Davis – Oferece uma visão sobre as considerações éticas no uso de big data.

- “Hadoop: The Definitive Guide” por Tom White – Uma fonte abrangente sobre o Hadoop, essencial para entender arquiteturas de big data baseadas em Hadoop.

- “High Performance MySQL” por Baron Schwartz, Peter Zaitsev, e Vadim Tkachenko – Um recurso detalhado sobre otimização de bancos de dados MySQL.

- “High Performance Spark” por Holden Karau e Rachel Warren – Aborda técnicas avançadas de otimização para Apache Spark.

- “Information Visualization: Perception for Design” por Colin Ware – Fornece um embasamento sobre a percepção visual e como ela se aplica na criação de visualizações eficazes de dados.

- “Interactive Data Visualization for the Web” por Scott Murray – Um guia prático sobre a criação de visualizações interativas usando D3.js.

- “NoSQL: Database for Storage and Retrieval of Data in Cloud” por Ganesh Chandra Deka – Fornece uma visão abrangente dos bancos de dados NoSQL e seu papel no armazenamento de dados na nuvem.

- “Practical Big Data Analytics” por Nataraj Dasgupta – Oferece insights práticos sobre a análise de big data, abordando diferentes modelos de dados.

- “Principles of Data Management and Governance” por John Ladley – Um guia para a governança de dados em um mundo dominado pelo big data.

- “Scalable Big Data Architecture” por Bahaaldine Azarmi – Explora arquiteturas de big data e práticas de escalabilidade.

- “SQL Performance Explained” por Markus Winand – Uma exploração detalhada da otimização de consultas SQL e indexação.

- “Streaming Systems: The What, Where, When, and How of Large-Scale Data Processing” por Tyler Akidau, Slava Chernyak, e Reuven Lax – Explora sistemas de processamento de streams em tempo real, uma parte crítica das arquiteturas modernas de big data.

- “Storytelling with Data” por Cole Nussbaumer Knaflic – Fornece técnicas para melhorar a comunicação de dados através de visualizações eficazes.

- “The Age of Surveillance Capitalism” por Shoshana Zuboff – Analisa como o big data está transformando as relações de poder na economia digital.

- “The Art of Scalability” por Martin L. Abbott e Michael T. Fisher – Um guia prático para escalonar aplicações, útil para entender como a modelagem de dados se encaixa na escalabilidade geral do sistema.

- “The Big Data-Driven Business” por Russell Glass e Sean Callahan – Explora como as empresas podem usar o big data para impulsionar estratégias e tomar melhores decisões.

- “The DAMA Guide to the Data Management Body of Knowledge” por DAMA International – Um recurso abrangente sobre as práticas de gerenciamento de dados, incluindo governança.

- “The Data Warehouse Toolkit: The Definitive Guide to Dimensional Modeling” por Ralph Kimball e Margy Ross – Aborda técnicas de modelagem para data warehousing, relevante para a compreensão das arquiteturas de big data.

- “The Enterprise Big Data Lake” por Alex Gorelik – Aborda a criação e gestão de data lakes em um ambiente empresarial.

- “The Functional Art: An Introduction to Information Graphics and Visualization” por Alberto Cairo – Oferece uma base sólida na teoria e prática da visualização de informações.

- “Trends in Big Data and Data Science: A Comprehensive Review” por A.K. Verma e B. Bhushan – Uma revisão das tendências emergentes em big data e ciência de dados, focando em integração e governança.

- “Weapons of Math Destruction” por Cathy O’Neil – Explora como big data e algoritmos podem ampliar a desigualdade social e a injustiça.

Leave a Comment